爬虫python的爬取步骤(爬虫python方法)

发布:2024-03-17 02:10:00 72

爬虫python的爬取步骤

1、以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。

2、这里假设我们爬取的是债券数据,主要包括年利率、借款标题、期限、金额和进度这5个字段信息,截图如下:打开网页源码中,可以发现数据不在网页源码中,按F12抓包分析时,才发现在一个json文件中。

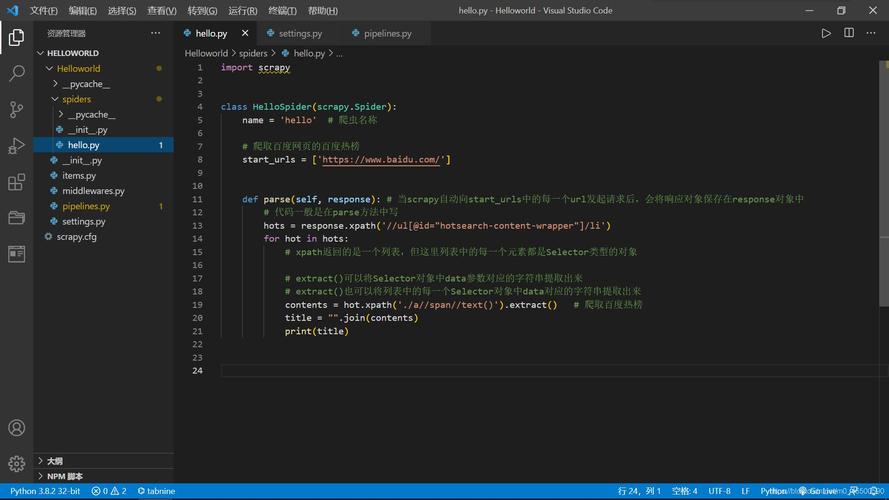

3、如下图所示,爬虫从编写的spider文件中的start_urls开始,这个列表中的url就是爬虫抓取的第一个网页,它的返回值是该url对应网页的源代码,我们可以用默认的parse(self。

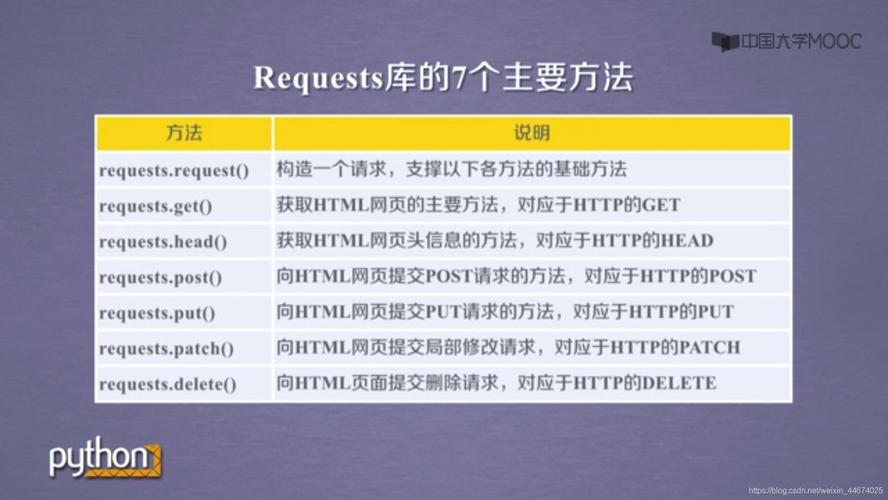

4、基本抓取网页 get方法 post方法 使用代理IP 在开发爬虫过程中经常会遇到IP被封掉的情况,这时就需要用到 代理IP;在urllib 2包中有Proxy Handler类, 通过此类可以设置代理 访问网页。

毕业生必看Python爬虫上手技巧

1、从爬虫必要的几个基本需求来讲:抓取 py的urllib不一定去用,但是要学,如果还没用过的话。比较好的替代品有requests等第三方更人性化、成熟的库,如果pyer不了解各种库,那就白学了。抓取最基本就是拉网页回来。

2、首先是获取目标页面,这个对用python来说,很简单。运行结果和打开百度页面,查看源代码一样。这里针对python的语法有几点说明。

3、Python的爬虫库其实很多,像常见的urllib,requests,bs4,lxml等,初始入门爬虫的话,可以学习一下requests和bs4(BeautifulSoup)这2个库,比较简单,也易学习,requests用于请求页面,BeautifulSoup用于解析页面。

4、Bloom Filter: Bloom Filters by Example 如果需要大规模网页抓取,游戏玩家需要学习分布式爬虫的概念。其实没那么玄乎,游戏玩家只要学会怎样维护一个所有集群机器能够有效分享的分布式队列就好。

如何使用爬虫获取网页数据python

1、这里假设我们抓取的数据如下,主要包括用户昵称、内容、好笑数和评论数这4个字段,如下:对应的网页源码如下,包含我们所需要的数据:对应网页结构,主要代码如下,很简单,主要用到requests+BeautifulSoup。

2、安装必要的库 为了编写爬虫,游戏玩家需要安装一些Python库,例如requests、BeautifulSoup和lxml等。游戏玩家可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

3、首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url)),获取目标网页的源代码信息(req.text)。

4、打开原网页,如下,这里假设要爬取的字段包括昵称、内容、好笑数和评论数:接着查看网页源码,如下,可以看的出来,所有的数据都嵌套在网页中:然后针对以上网页结构,我们就可以直接编写爬虫代码。

5、模拟请求网页。模拟浏览器,打开目标网站。获取数据。打开网站之后,就可以自动化的获取我们所需要的网站数据。保存数据。拿到数据之后,需要持久化到本地文件或者数据库等存储设备中。

python爬虫的工作步骤

1、使用Python编写网络爬虫程序的一般步骤如下: 导入所需的库:使用import语句导入所需的库,如BeautifulSoup、Scrapy和Requests等。 发送HTTP请求:使用Requests库发送HTTP请求,获取网页的HTML源代码。

2、Python爬虫入门(第1部分)如何使用BeautifulSoup对网页内容进行提取 Python爬虫入门(第2部分)爬虫运行时数据的存储数据。

3、以下是使用Python3进行新闻网站爬取的一般步骤: 导入所需的库,如requests、BeautifulSoup等。 使用requests库发送HTTP请求,获取新闻网站的HTML源代码。 使用BeautifulSoup库解析HTML源代码,提取所需的新闻数据。

如何用python爬取网站数据

1、1)首先确定需要爬取的网页URL地址;2)通过HTTP/HTTP协议来获取对应的HTML页面;3)提取HTML页面里有用的数据:a.如果是需要的数据,就保存起来。b.如果是页面里的其他URL,那就继续执行第二步。

2、selenium是一个自动化测试工具,也可以用来模拟浏览器行为进行网页数据抓取。使用selenium库可以执行JavaScript代码、模拟点击按钮、填写表单等操作。

3、Python快速上手的7大技巧 Python快速上手爬虫的7大技巧 基本抓取网页 get方法 post方法 使用代理IP 在开发爬虫过程中经常会遇到IP被封掉的情况,这时就需要用到 代理IP;在urllib 2包中有Proxy Handler类。

4、对应网页结构,主要代码如下,很简单,主要用到requests+BeautifulSoup,其中requests用于请求页面,BeautifulSoup用于解析页面:程序运行截图如下,已经成功爬取到数据:抓取网站动态数据(数据不在网页源码中。

- 上一篇:网瘾少年真实案例(网瘾少年最后的结果)

- 下一篇:网页前端和后端怎么连接起来

相关推荐

- 03-17ceshi444

- 03-17投屏投影仪怎么用(投影仪投屏器使用方法)

- 03-17自动检测删除微信好友软件—自动检测删除微信好友软件免费

- 03-17win11平板键盘不自动弹出、win10平板模式键盘不出来

- 03-17电脑忽然严重掉帧

- 03-17只输入真实姓名找人抖音、只输入真实姓名找人抖音怎么弄

- 站长推荐

- 热门排行

-

1

最后的原始人腾讯版下载-最后的原始人腾讯版2023版v4.2.6

类别:休闲益智

11-18立即下载

-

2

坦克世界闪击战亚服下载-坦克世界闪击战亚服2023版v2.1.8

类别:实用软件

11-18立即下载

-

3

最后的原始人37版下载-最后的原始人37版免安装v5.8.2

类别:动作冒险

11-18立即下载

-

4

最后的原始人官方正版下载-最后的原始人官方正版免安装v4.3.5

类别:飞行射击

11-18立即下载

-

5

砰砰法师官方版下载-砰砰法师官方版苹果版v6.1.9

类别:动作冒险

11-18立即下载

-

6

最后的原始人2023最新版下载-最后的原始人2023最新版安卓版v3.5.3

类别:休闲益智

11-18立即下载

-

7

砰砰法师九游版下载-砰砰法师九游版电脑版v8.5.2

类别:角色扮演

11-18立即下载

-

8

最后的原始人九游版下载-最后的原始人九游版微信版v5.4.2

类别:模拟经营

11-18立即下载

-

9

汉家江湖满v版下载-汉家江湖满v版2023版v8.7.3

类别:棋牌游戏

11-18立即下载

- 推荐资讯

-

- 02-17ceshi444

- 11-18神魔大陆鱼竿在哪买(神魔大陆怀旧版)

- 11-21投屏投影仪怎么用(投影仪投屏器使用方法)

- 11-23侠盗飞车4自由城(侠盗飞车圣安地列斯秘籍)

- 11-23自动检测删除微信好友软件—自动检测删除微信好友软件免费

- 11-25战争机器v1.2修改器(战争机器5十一项修改器)

- 11-27防御阵型觉醒2攻略(防御阵型觉醒通关教程)

- 11-27斗战神新区赚钱攻略(斗战神新区开服表)

- 11-27win11平板键盘不自动弹出、win10平板模式键盘不出来

- 11-27电脑忽然严重掉帧